Der vorliegende Blogbeitrag soll den aktuellen Forschungsstand bezüglich der Debatte, ob und unter welchen Bedingungen die Metrik von Ratingskalen als (quasi-)intervall- oder ordinalskaliert betrachtet werden können, zusammenfassend darlegen. Darüber hinaus diskutiere ich die teilweise konträren Perspektiven der Forschenden auf Basis testtheoretischer Erkenntnisse (meine persönliche Ansicht kennzeichne ich dabei mit einem Pfeil „–>“). Ferner liefere ich ein Beispiel für die fatalen Folgen, welche unter der Annahme „gerade Ratingskalen mit verbalen Markern sind (quasi-)intervallskaliert“ eintreten können und schließe den Beitrag mit einem Fazit, sowie einer Checkliste anwendungsorientierter Handlungsempfehlungen ab.

Döring & Bortz (2016) schreiben:

- Eine Skala mit sehr wenigen Stufen (3-4 Stufen) liefert undifferenzierte Urteile, die maximal Ordinalskalenniveau besitzen (Matell & Jacoby, 1971).

- Eine Stufenzahl zwischen fünf und sieben Stufen hat sich in der Praxis bewährt und liefert psychometrisch die besten Validitäten und Reliabilitäten (Dawis, 1987; Lissitz & Green, 1975; Lozano, Garcia-Cueto & Muniz, 2008; Preston & Colman, 2000; Rohrmann, 1978).

- Gemeinsames Problem von Ratingskalen: Garantiert eine detaillierte Instruktion und eine sorgfältige Skalenkonstruktion, dass die Befragungspersonen intervallskalierte Urteile abgeben? Die Kontroverse zu dem Thema hat eine lange Tradition und scheint bis heute kein Ende zu finden: a) Messtheoretiker: Ratingskalen sind nicht intervallskaliert, b) Pragmatiker: die Verletzung der Intervallskaleneigenschaft sei bei Ratingskalen nicht so gravierend. In diesem Zusammenhang sei auf ein Missverständnis aufmerksam gemacht, dass seit Einführung der vier wichtigsten Skalenarten durch Stevens (1946, 1951) nur schwer auszuräumen ist: mathematisch gesehen, setzen parametrische inferenzstatistische Skalen kein bestimmtes Skalenniveau voraus, vielmehr besteht das Problem in der messtheoretischen Interpretation, wie Gaito (1980) diskutiert, da die Mittwerte demnach keine inhaltliche Bedeutung haben (Hand, 1996; King et al., 2010; Michelle, 1986; Stine, 1989). Es geht also um die inhaltlich sinnvolle Interpretation der Ergebnisse – solange einem diese gleichgültig ist, könne man gerne Varianzanalysen mit Lottozahlen oder Telefonnummern rechnen (Lord, 1953).

- Ratingskalen werden meist als intervallskaliert aufgefasst. Bei Zweifel an Gleichabständigkeit (Äquidistanz) der Stufen, wird diese als ordinalskaliert betrachtet –> wichtig: sind die Abstände zwischen den einzelnen Antwortoptionen augenscheinlich gleichabständig? Ist das bei geraden Ratingskalen mit verbalen Markern an allen Antwortoptionen überhaupt möglich? Nein ist es nicht, da der Abstand zischen den beiden mittleren Kategorien größer ist als zwischen allen anderen Antwortoptionen. Gerade Ratingskalen mit verbalen Markern an allen Antwortoptionen sind somit höchstens ordinalskaliert. Die Mittelwerte solcher Ratingskalen sind inhaltlich nicht sinnvoll interpretierbar, es muss statistische Verfahren zurückgegriffen werden, welche für ordinalskalierte Daten zugeschnitten sind. An sich ist das keine Tragödie, die Herausforderung dabei ist nur, dass die Testpower / Teststärke (1-ß; diese kann man z.B. mit der Software G*Power von Faul, Erdfelder, Lang, & Buchner, berechnet werden – das ist keine Werbung für diese Software, sondern lediglich eine mögliche Option der Berechnung) dieser Verfahren geringer ist und es somit einen größeren Stichprobenumfang braucht, um einen tatsächlich vorhandenen Unterschied oder Zusammenhang bei gleichbleibender Irrtumswahrscheinlichkeit (z.B. p = .05 oder .01) überhaupt als diesen zu erkennen.

- Ratingskalen mit gleichabständiger Etikettierung und mindestens fünf Stufen als intervallskaliert aufzufassen, hat sich in der Forschungspraxis eingebürgert. Möglicher Umgang mit dem Streitthema: Einmal mit Verfahren für Ordinaldaten und einmal mit Verfahren für Intervalldaten rechnen und Ergebnisse vergleichen ( –> z.B. für Unterschiede bei zwei Gruppen einmal mit dem T-Test für unabhängige Stichproben und einmal mit Mann-Whitney-U-Test, bzw. für Zusammenhänge die Produkt-Moment-Korrelation versus die Spearman Rangkorrelation berechnen; Bortz & Schuster, 2010). Diese Vorgehensweise kommt in der Regel (mathematisch) zu einem ähnlichen Ergebnis (dem Test ist egal, ob die Daten formal intervall- oder ordinalskaliert sind), womit die Hypothese, jene Art von Ratingskalen als intervallskaliert zu deklarieren unter den genannten Voraussetzungen vertretbar scheint.

- Einheit und Ursprung einer Ratingskala sollten intra- und interindividuell konsistent verstanden werden. Bereits geringfügige Itemänderungen bzw. Änderungen im Skalenformat, beeinflussen das Antwortformat (Kahnemann & Tversky, 2000; Krosnick & Fabrigar, 2006). Dabei empfiehlt sich, dass die Rater vor ihrer Beurteilung alle Untersuchungsobjekte kennenlernen, damit verhindert werden kann, dass Objekte mit extremen Merkmalsausprägungen nicht mehr korrekt eingestuft werden, weil die Extremwerte zuvor bereits für Objekte mit weniger extremen Merkmalsausprägungen vergeben wurden. So können Decken- und Boden-Effekte vermieden werden (d.h. Objekte, die sich in ihrer Merkmalsausprägung ähneln, jedoch nicht genau gleich sind, sollten dennoch unterschieden werden). Unterstützen können hier verbale Marker – zusätzlich zu Zahlen, die über jedem Antwortformat stehen, sollten und die Antwortoptionen in gleich große Intervalle aufteilen (McCarty & Shrum, 2000).

- Zu beachten ist außerdem das Merkmalskontinuum. Werden viele Positive, aber nur wenige negative Objekte auf einer Bewertungsskala eingestuft, ist damit zu rechnen, dass die positiven Objekte feiner differenziert werden als die Negativen. Die Wahrscheinlichkeit intervallskalierter Ratingskalenurteile wird deshalb erhöht, wenn die Objekthäufigkeiten auf beiden Seiten der Skala symmetrisch sind bzw. wenn der mittlere Wert der Skala mit dem Medianwert der Häufigkeitsverteilung zusammenfällt (= Normalverteilung; vgl. das „Range-Frequency-Model“ von Parducci, 1963, 1965; Informationen diesbezüglich liefert demnach die Verteilung der Daten; grafisch sowie über die Itemschwierigkeit, die im Idealfall zwischen .20 und .80 liegt). –> Die Itemschwierigkeit kann übrigens variiert werden, durch Umformulierung der Items (aber das ist ein anderes Thema – man muss ja nicht jedes Fass innerhalb eines Blogbeitrags komplett ausschöpfend öffnen).

Was berichten Baur & Blasius (2014) zu dem Thema? Es folgt eine Übersicht:

- Alles in allem sprechen die einschlägigen Ergebnisse dafür, in allgemeinen Bevölkerungsbefragungen fünfstufige oder siebenstufige Skalen zu verwenden (vgl. auch Faulbaum et al. (2009) für eine ähnliche Empfehlung).

- Empirisch sprechen die Ergebnisse eher für ungerade Skalen. Bei einem Vergleich zwischen 5-stufigen und 6-stufigen Antwortkategorien konnte Moors (2008) allerdings kein wesentlichen Unterschiede erkennen. O’Muircheartaigh et al. (2000) berichten dagegen eine bessere Reliabiliät für Skalen mit einer mittleren Kategorie.

- Um zu vermeiden, dass Befragte die mittlere Kategorie wählen, weil sie damit ihre Meinungslosigkeit zum Ausdruck bringen wollen, wird gelegentlich die explizite Verwendung einer „weiß nicht“ Kategorie empfohlen (Converse & Presser, 1986). Dies wird in der einschlägigen Literatur aber kritisch gesehen (vgl. den ausführlichen Literaturüberblick in Krosnick, 1999). Eine explizite „weiß nicht“ Kategorie erhöht den Anteil an Befragten, die angeben, keine Meinung zu einem Thema zu haben. Dieser höhere Anteil ist aber nur teilweise auf wirkliche Meinungslosigkeit zurückzuführen. Darüber hinaus wird die „weiß nicht“ Option auch gerne genutzt, um den kognitiven Aufwand zu reduzieren, eine Frage zu verstehen und zu beantworten. Insgesamt zeigen die Studien, dass explizite „weiß nicht“ Kategorien die Reliabilität nicht erhöhen (Bauer & Blasius, 2014, S. 670). –> Ich persönlich tendiere dennoch zur Verwendung einer „weiss nicht“ Kategorie, insbesondere beim erstmaligen Einsatz eines Fragebogens, der noch in der Entwicklung ist und bspw. zunächst einmal im Rahmen eines Pretests erprobt wird. Grund: 1) betrachtet man nur die Reliabilität, so wäre es eine fehlerhafte Messung, so zu tun, als gäbe es keinen einzigen Probanden, der tatsächlich die Antwort auf die ein oder andere Frage nicht kennt. Im Klartext: verzichtet man auf die „weiss nicht“ Kategorie, so produziert man eine ggf. unreliable Messung, da eine Person, welche die Antwort tatsächlich nicht kennt, entweder a) gezwungen wird, sich für eine für sie unzutreffende Kategorie zu entscheiden (das trifft übrigens auch für gerade Ratingskalen zu, bei denen es den Teilnehmern nicht zugestanden wird, eine mittlere Kategorie anzukreuzen) oder b) gar nicht erst antwortet, was wiederum zu fehlenden Werten führt (ein äußerst dramatisches und ganzes eigenes Thema für sich…ein Übersichtsartikel diesbezüglich ist von mir in Vorbereitung). 2) mit Hilfe der „weiss nicht“ Kategorie kann man herausfinden, ob die Fragen von der Stichprobe für die der Fragebogen konzipiert wird überhaupt beantwortet werden können (ob die Probanden die notwenigen Informationen / ausreichend Wissen zur Beantwortung der Frage haben). Die „weiss nicht“ Kategorie kann demnach also nicht nur „Fluch“ sondern auch „Segen“ sein. 🙂

- Eine Beschriftung oder Verbalisierung aller Kategorien einer Antwortskala ist nur bei Skalen bis zu 7 oder 9 Kategorien sinnvoll. Bei längeren Skalen ist es schwierig, eine angemessene verbale Abstufung zu konstruieren. In diesem Fall werden in der Regel nur die Endpunkte mit z.B. „stimme sehr stark zu“ oder „stimme überhaupt nicht zu“ bezeichnet.

- Auf den ersten Blick erscheinen nummerierte Antwortkategorien präzisere Abstufungen zu ermöglichen als verbale Differenzierungen. Empirische Studien zeigen aber, dass die semantische Kennzeichnung der einzelnen Antwortkategorien zu einer besseren Reliabilität führt (z.B. Krosnick 1999, Tourangeau et al. 2007). Falls eine Beschriftung aufgrund der Abstufungen möglich ist, dann sollte sie auch gewählt werden.

- Bei der Verbalisierung der Kategorien von Ratingskalen ist darauf zu achten, dass die Bezeichnungen möglichst gleiche Intervallabstände nahelegen. Das ist bei fünf oder siebenstufigen Skalen leicht durchführbar. Die Antwortkategorien bei Zustimmungsfragen lauten dann z.B. „stimme sehr zu“, „stimme eher zu“, stimme teilweise zu/teilweise nicht“, „stimme eher nicht zu“ und „stimme überhaupt nicht zu“. Bei siebenstufigen Skalen würde man die Skala um extremere Endpunkte z.B. „stimme absolut zu“ und „stimme absolut nicht zu“ erweitern. Falls in schriftlichen Befragungen gleichzeitig numerische Werte präsentiert werden, dann sollten sie gleichsinnig vergeben werden, also bspw. die Ziffer 5 für die Ausprägung „stimme sehr zu“ und die Ziffer 1 für die Ausprägung „stimme überhaupt nicht zu“. –> Andererseits sprechen sich Moosbrugger und Kelava (2012) für eine aufsteigende Reihenfolge nummerischer Marker mit dem Beginn bei der Ziffer 0 aus. Grund: wenn ich „gar nicht zustimme“, warum sollte ich dann den Wert „1“ erhalten, meine Ausprägung ist ja in keinster Weise vorhanden, also entspricht sie (von der Logik her) eher einer Null als einer Eins. Ein durchaus nachvollziehbares Argument finde ich.

- Die Beschriftung durch semantische Differenziale kann ebenso wie eine unipolare Bezeichnung mit positiven numerischen Werten kombiniert werden (beispielsweise von 1 bis 7). Empirische Studien haben gezeigt, dass Befragte zusätzlich zu der Verbalisierung den verwendeten Ziffern eine Bedeutung zuschreiben. So werden negative Ziffern eher gemieden als positive Zahlen (Schwarz et al. 1991). Gleichmäßige Abstufungen werden daher besser erreicht, wenn unipolare Formulierungen auch mit einem positiven Wertebereich der Ziffern kombiniert werden.

- Streng genommen handelt es sich bei Ratingskalen um ordinale Messniveaus. Ob die Skalenabstände darüber hinaus gleich sind und die Skala damit Intervallskalenniveau aufweist, ist eine empirische Frage, die durch geeignete statistische Verfahren (z.B. Item-Response-Theorie) getestet werden kann (Geiser/Eid 2010, Rost 2004). Es empfiehlt sich auch, bei der statistischen Auswertung die Ergebnisse der Analyseverfahren für intervallskalierte Daten (z.B. OLS-Regressionen) mit Ergebnissen für ordinale Daten (z.B. logistische Regressionen) zu vergleichen. Auf der sicheren Seite ist man dann, wenn unterschiedliche Analyseverfahren zu vergleichbaren Ergebnissen kommen.

- Unipolar wird die Abstufung mit den Labels „stimme sehr stark zu“ bis „stimme überhaupt nicht zu“ erreicht. Befragte kommen bei einer Befragung besser mit möglichst einfachen Antwortskalen zurecht, die schnell erlernt werden können und die nicht bei jeder Frage neu beachtet werden müssen. Diese Regel, Befragungen möglichst einfach zu halten, spricht daher für die Verwendung unipolarer Skalen. Dies scheinen auch empirische Studien zu bestätigen (Schaeffer & Presser, 2003).

Bühner (2011) hat der Thematik ebenfalls seine Aufmerksamkeit gewidmet:

- Differenzierungsgrad: Validität und Reliabilität steigen, wenn mehr Antwortkategorien benutzt werden. Preston und Colmann (2000) berichten, dass eine siebenstufige Antwortskala unter beiden Gesichtspunkten besonders vorteilhaft ist. Ab 7 Stufen, gibt es keinen weiteren Anstieg der Reliabilität und Validität (Faulbaum, Prüfer & Rexroth, 2009).

- Maydeu-Olivares et al. (2009): mit zunehmender Anzahl der Antwortkategorien nimmt die Reliabilität zwar zu, doch die Modellanpassung, insbesondere bei längeren Tests, nimmt ab.

- Verbale Abstufungen und Intensität: liegen diese zu nah beieinander (z.B. gelegentlich gefolgt von manchmal) oder sind sie nicht eindeutig, kann dies zu Problemen führen und wirkt sich negativ auf die Messeigenschaft aus.

- Krosnick (1999) berichten, dass eine Benennung jeder Stufe bei einer Ratingskala zu Verbesserungen der Messgenauigkeit und der Validität führt. Es besteht auch die Möglichkeit, nummerische und verbale Abstufungen gemeinsam zu verwenden, in manchen Fällen werden auch nur die Pole benannt.

- Auch hier wird die Verwendung von mittleren Kategorien kontrovers diskutiert. Die Entscheidung darüber sollte in Abwägung folgender Fragen fallen:

- Soll die Reliabilität der Skala maximiert werden? Dann: 5-7 Antwortformate. Nachteil: Kritik an Mittelkategorie + höhere Wahrscheinlichkeit einer Modellablehnung im Rahmen von konfirmatorischen Faktoranalysen oder im Rahmen von Rasch-Modellen. –> Die Kritik an der Mittelkategorie wird teilweise überschätzt, da die grundsätzliche Entscheidungsunfreude ein individuelles Persönlichkeitsmerkmal darstellt (und somit stichprobenabhängig ist), was bei weitem nicht jedes Subjekt betrifft UND es ebenso eine Tendenz zu Extremen gibt. Relativ leicht beantworten kann man sich die Frage, ob die Furcht von der Tendenz zur Mitte für die mir individuell vorliegenden Daten berechtigt ist, indem man sich die Verteilungen der Individualwerte sowie zentrale Tendenzen anschaut – häufig zeigt die nämlich ein ganz anderes Bild: Boden- und Deckeneffekte. In dem Fall kann man getrost zur Mitte greifen und sollte möglicherweise eher mal darüber nachdenken, die Itemschwierigkeit durch umformulieren der Items zu optimieren.

- Soll verhindert werden, dass die Mittelkategorie unterschiedlich aufgefasst wird? Mittelkategorie streichen und eine sechsstufige Skala verwenden. Nachteil: Personen mit wirklich neutralen Eigenschaftsausprägungen können nicht korrekt antworten –> Achtung Messfehler!

- Wie wird in der Regel das Bearbeiten einer Ratingskala erleichtert? Eine sprachliche Verankerung der Antwortstufen sowie Zahlen zur Visualisierung verwenden. Die verbale Verankerung sollte dabei möglichst gleichabständig und eindeutig gewählt werden (Rohrmann, 1978).

Vor dem abschließenden Fazit möchte ich anhand eines Beispiels auf die potenziell fatalen Folgen (aufgrund falscher Schlussfolgerungen) hinweisen, welche durch die falsche Annahme „geraden Ratingskalen mit verbalen Markern sind intervallskaliert“ eintreffen können.

Wird jede Antwortoption einer geraden Ratingskala mit einem verbalen Marker erläutert, so ist bereits augenscheinlich die Annahme der Aquidistanz (= Gleichabständigkeit; Wirtz, 2002) zwischen den beiden mittleren Antwortoptionen verletzt. Nach Hole (2011) weist eine 6-stufige Skala mit verbalen Markern maximal ein ordinalskaliertes Niveau auf. Dies lässt sich an folgendem Beispiel (Tabelle 1) visualisieren (leider nicht so schön wie ich es gerne hätte, da meine Programmierkenntnisse von Webseiten es nicht zulassen aber versuchen wir es dennoch): Angenommen zwei Rater schätzen ein und dasselbe Objekt (auf einer 6-stufigen Skala mit verbalen Makern für jede Antwortoption) ein. Dasselbe Objekt wird anschließend nochmal von zwei anderen Ratern beurteilt. In beiden Fällen weichen die Rater um nur einen Skalenpunkt voneinander ab, dennoch ergeben sich gravierend Unterschiede, welche – unter Annahme der Intervallskalierung – fälschlicherweise nicht erkannt werden.

Tabelle

1

Beispiel:

die Problematik der Skalierung bei der Beurteilerübereinstimmung /

Interraterreliabilität

|

Rater 1 |

Rater 2 |

Rater 3 |

Rater 4 |

| Einschätzungen

für Objekt 1 |

3 (selten) |

4 (oft) |

5 (sehr oft) |

6 (immer) |

Anmerkung. Fiktives Beispiel von Raterwerten auf einer 6-stufigen Ratingskala (1 = nie, 2 = sehr selten, 3 = selten, 4 = oft, 5 = sehr oft, 6 = immer). Auf die Darstellung der Merkmalsausprägung 1 (nie) und 2 (sehr selten) wurde aus Gründen der Übersichtlichkeit verzichtet, da kein Rater diese Einschätzung für das vorliegende fiktive Beispiel

Objekt 1 angenommen hat.

Abweichung Rater 1 und 2: nur ein Skalenpunkt, obwohl Rater 1 der Meinung ist, dass das Kind jenes Verhalten

selten zeigt und Rater zwei der Meinung ist, dass besagtes Verhalten

oft gezeigt wird. Abweichung Rater 3 und 4: ebenfalls nur ein Skalenpunkt, Rater 3 ist der Meinung, dass besagtes Verhalten

sehr oft auftritt wohingegen Rater 4 das Verhalten angeblich

immer beobachtete.

Irrtümlicherweise wird bei ausschließlicher Betrachtung der Zahlenwerte rechnerisch angenommen, dass sich die Rater 1 und 2 in Ihrer Einschätzung

ebenso ähnlich sind, sie Rater 3 und 4, da beide Rater-Paare ja nur einen Skalenpunkt in Ihrer Wertung voneinander abweichen. Diese Interpretation wäre jedoch grundlegend

falsch und schränkt die Messgenauigkeit (Reliabilität) und Trennschärfe des Fragebogens – unter dieser Annahme – massiv ein.

Ein weiteres Problem gerader Antwortformate ist messtheoretisch begründet. Durch den Zwang auf das Ausweichen auf andere Kategorien, kann es zu einer systematischen Datenverzerrung kommen. Ein guter Fragebogen sollte der Person die diesen ausfüllt eine wahrheitsgetreue Antwort zugestehen, auch wenn diese zu einer neutralen Position führt (Toister, 2018). Wird diese Option weggelassen, wird ungerechtfertigterweise grundlegend davon ausgegangen, dass jedes Verhalten, welches mit dem Items angesprochen wird, naturgemäß nicht manchmal / teilweise

auftreten kann. Das ist eine fehlerhafte Annahme.

Indifferenz und Ambivalenz können ohne Mittelkategorie nicht erkannt werden. Laut Jäger (1985) und Stier (1999) führt die Verwendung einer ungeraden Ratingskala mit Mittelkategorie (ergänzt durch die Option

kann ich nicht beurteilen) – trotz der langjährigen und fast schon traditionellen Kritik an einer Mittelkategorie – zur unversehrtesten Informationsgewinnung (Jäger, 1985; Stier, 1999). Überblicke liefern auch Cox (1980), Krosnick & Fabrigar (1997), Dawes & Smith (1985), Foddy (1992), Haertel (1993), McIver & Carmines (1993) und Spector (1993).

Die Vermeidung von Mittelpunkten auf Ratingskalen wird also nur dann und auch nur in Ausnahmefällen empfohlen, wenn

a) von einer hohen sozialen Erwünschtheit (inhaltliche Antworttendenz) ausgegangen werden kann und die tatsächliche Einstellung bzw. die Übernahme der Verantwortung bei folgenreicher Konsequenz vermieden werden soll (Bspw. wenn Eltern einen Fragebogen für ihr Kind ausfüllen und diese die Befürchtung hegen, dass mit den Ergebnissen Rückschlüsse auf einen gewaltfreien Erziehungsstil gezogen werden).

b) einer naturgemäß extremen Vorkommensweise des Verhaltens unterstellt werden kann.

c) viele „weiss nicht“ Antworten zu erwarten sind und die Mitte somit die Gefahr birgt, als Ausdruck von Ausweichungen auf Grund mangelnder Motivation oder grundlegend unsicherer Persönlichkeitseigenschaften zu fungieren. Dies würde ebenfalls zu verzerrten Daten führen,

kann jedoch relativ einfach durch eine weitere Kategorie (

kann ich nicht beurteilen) behoben werden. Die massenweise Produktion fehlender Werte kann durch einen Appell in der Einleitung, wie beispielsweise „

bitte denken Sie in Ruhe nach, welche Antwortoption zutreffen könnte, gehen Sie

gedanklich all jene Situationen durch in der das besagte Verhalten gezeigt wurde und entschieden Sie sich für die Antwortoption, welche am ehesten

zutrifft. Kreuzen Sie die Kategorie „kann ich nicht beurteilen“ bitte nur dann an, wenn Sie tatsächlich keine Situation beobachtet haben in der das besagte Verhalten auftrat“ reduziert werden

.

Auch kann mit Hilfe eines Pretest die Anzahl fehlender Werte pro Frage kontrolliert werden. In einem nächsten Schritt könnten Items mit vielen fehlenden Werten hinsichtlich ihrer Verständlichkeit (klare und deutliche Formulierung) überarbeitet und das Risiko des Ankreuzens einer mittleren Ausprägung durch

Unwissenheit reduziert werden.

d) auf ein intervallskaliertes Niveau verzichtet werden kann. Statistisch unumstritten bleibt, dass die fehlende mittlere Ausprägung ordinalskalierte Daten produziert, bei denen weder die Berechnung eines Mittelwertes, noch die Datenanalyse mit gängigen parametrischen Verfahren (z.B. Faktorenanalyse) erlaubt und sinnhaft ist.

e) ausschließlich die Enden der Ratingskala mit verbalen Markern beschriftet werden, alle anderen Ausprägungen lediglich mit nummerischen Markern (in diesem Ausnahmefall kann auch bei geraden Ratingskalen (ab 6 Stufen) von einem intervallskalierten Niveau ausgegangen werden).

Fazit:

- Höchstmögliches Skalenniveau verwenden, im Idealfall intervallskaliert (Prost, 2011; Baur & Blasius, 2014) –> ich nenne das höchstmögliche Skalenniveau von Ratingskalen auch gerne „quasi-intervallskaliert“, da sie ganz genau genommen, selbst unter idealen Bedingungen durch Individuen beantwortet werden, damit stets messfehlerbehaftet und somit nie wirklich intervallskaliert (wie bspw. ein Thermometer oder eine Waage) sein können.

- Optimale Antwortkategorien: sieben plus/minus zwei Stufen (Baur & Blasius, 2014) bzw. 5-7 Stufen (Prost, 2011). Westermann, 1985, S. 265: Ratingskalen sind als intervallskaliert annehmbar, sollten jedoch mindestens 5-7 Stufen haben und ungerade sein, damit gleiche Abstände gewährleistet sind (Bühner, 2011).

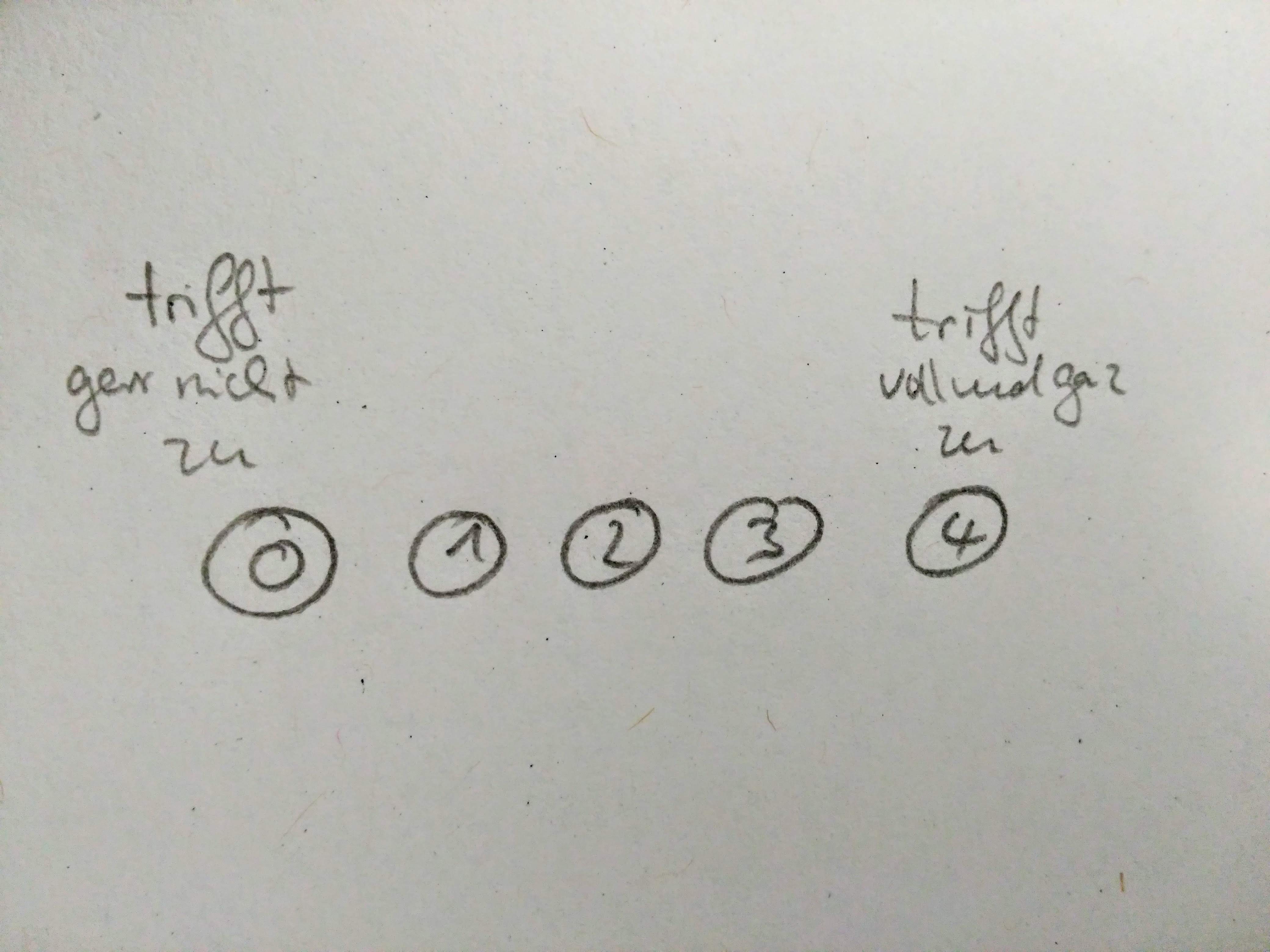

- Positive Ziffern, aufsteigend nummeriert, beginnend bei Null (0)

- Ungerade besser als gerade (Baur & Blasius, 2014; Prost, 2011) wenn ungerade, dann ggf. „kann ich nicht beurteilen“ hinzufügen, um Antworttendenz + Gleichgültigkeit zu vermeiden; wobei sich hier unterschiedliche Sichtweisen finden lassen (siehe oben)

- Verbale Marker tragen zur Verständlichkeit bei, sind aber ordinalskaliert; Nummerische Marker sind je nach Abstufung intervallskaliert, aber nicht so leicht verständlich wie verbale –> Ideal: beides kombinieren, positive Zahlen und Beschriftung jeder Antwortkategorie (Bsp. Baur & Blasius, 2014).

- Man kann über verschiedene Verfahren testen, ob die gewählte Ratingskala das optimale Antwortformat hat (Näheres in Baur & Blasius, 2014 oder Döring & Bortz, 2016).

- Prost (2011) sowie Wirtz & Caspar (2002, S. 125): bipolare Extreme, Endpunkteskala.

- Keine optische Verstärker, z.B. Keil, nötig (Prost, 2011).

Ratingskalen dürfen also als quasi-intervallskaliert angesehen werden, wenn:

- die Äquidistanz (Gleichabständigkeit) zwischen allen Ausprägungen nicht augenscheinlich verletzt ist (in der Regel ungerade Ratingskalen).

- sie empirisch überprüft wurden (z.B. „nie, (sehr selten), selten, gelegentlich, oft, (sehr oft), immer“ nach Rohrmann, 1978).

- sie mindestens 5 Abstufungen haben.

- für jede Abstufung (und für jedes Item) nummerische Marker vorliegen (Bspw. ,,0, 1, 2, 3, 4″).

- in Ausnahmefall gerade Ausprägungen (welche mindestens sechsstufig sein müssen) sollten die verbalen Marker nur an den Endpunkten stehen, nicht bei jeder Ausprägung (Bspw. nie 0, 1, 2, 3, 4 immer).

- Merke: bei ungeraden Ratingskalen (ab 5-stufiger Ausprägung und mit nummerischen Markern) spielt es keine Rolle, ob diese bei jeder Ausprägung durch verbale Marker ergänzt werden oder nur an den Skalenenden. Sie können in beiden Fällen als quasi-intervallskaliert betrachtet werden. Ihre Äquidistanz ist nicht augenscheinlich verletzt. Wir dürfen (zumindest was die Voraussetzung des Skalenniveaus betrifft) parametrische Verfahren anwenden, haben damit die höchstmögliche Testpower und brauchen gleichzeitig nur den geringstnötigen Stichprobenumfang. Yeeeehhhhaaaa!

Sodele, das war es von meiner Seite zu dem Thema. Ich schreibe nach bestem Wissen und Gewissen, aber man lernt ja nie aus, daher –> Anmerkungen, Korrekturvorschläge und konstruktive Kritik gerne an mich! 🙂

Literatur (noch nicht ganz vollständig)

Baur, N. & Blasius, J. (2014).

Handbuch Methoden der empirischen Sozialforschung. Heidelberg: Springer-Verlag.

Bortz, J., & Schuster, C. (2010).

Statistik für Human- und Sozialwissenschaftler (7., vollständig überarbeitete und erweiterte Auflage). Heidelberg: Springer-Verlag.

Bühner, M. (2011).

Einführung in die Test- und Fragebogenkonstruktion. München: Pearson Studium.

Converse, J. M., & Presser, S. (1986).

Survey questions: Handcrafting the standardized questionnaire. Newbury Park, CA: Sage Publications.

Cox, E. P. (1980). The optimal number of response alternatives for a scale: a review. Journal of Marketing Research,

17, 407-422.

Dawes, R. M., & Smith, T. L. (1985). Attitude and opinion measurement. In R. P. Abelson & A. Levy (Eds.), Handbook of social psychology (Vol. I, pp. 509-566). New York: Random House.

Dawis, R. V. (1987). Scale construction.

Journal of Counseling Psychology, 34(4), 481-489. doi: https://psycnet.apa.org/record/1988-18854-001

Döring, N. & Bortz, J. (2016).

Forschungsmethoden und Evaluation in den Sozial- und Humanwissenschaften (5. Aufl.). Heidelberg: Springer-Verlag.

Faulbaum, F., Prüfer, P. & Rexroth, M. (2009).

Was ist eine gute Frage? Die systematische Evaluation der Fragenqualität. Wiesbaden: VS Verlag.

Foddy, W. (1992).

Constructing questions for interviews and questionnaires: theory and practice in social research. Cambridge: Cambridge University Press.

Gaito, J. (1980). Measurement scales and statistics: Resurgence of an old misconception.

Psychological Bulletin, 87(3), 564-567.

http://dx.doi.org/10.1037/0033-2909.87.3.564

Geiser, C., & Eid, M. (2010). Item-Response-Theorie. In C. Wolf & H. Best (Hrsg.).

Handbuch der sozialwissenschaftlichen Datenanalyse (S. 311-332). Wiesbaden: VS Verlag für Sozialwissenschaften.

Hand, D.J. (1996). Statistics and the Theory of Measurement.

Journal of the Royal Statistical Society, Ser. A,

159(3), 445–492.

Härtel, C. E. J. (1993). Rating Format Research Revisited: Format Effectiveness andAcceptability Depend on Rater Characteristics.

Journal of Applied Psychology, 78(2), pp. 212-217.

Hole, G. (2011).

Research Skills: Levels of Measurement. Verfügbar unter: http://users.sussex.ac.uk/~grahamh/RM1web/Levels%20of%20Measurement.pdf

Kahneman, D. & Tversky, A. (Hrsg.). (2000).

Choices, values and frames. Cambridge University Press, Cambridge.

Krosnick, J. A. & Fabrigar L. R. (1997). Designing rating scales for effective measurement in surveys. In L. Lyberg, P. Biemer, M. Collins, E. de Leeuw, C. Dippo, N. Schwarz, & D. Trewin (Eds.), Survey measurement and process quality (pp. 141-164). New York: John Wiley & Sons, Inc.

Krosnick, J. A. (1999). Survey research.

Annual Review of Psychology, (50)537-567. doi:10.1146/annurev.psych.50.1.537

Krosnick, J. A. & Fabrigar, L.R. (2006).

The handbook of questionnaire design. New York: Oxford University Press.

Lissitz, R. W., & Green, S. B. (1975). Effect of the number of scale points on reliability: A Monte Carlo approach.

Journal of Applied Psychology, 60(1), 10-13.

Lord, F. M. (1953). On the Statistical Treatment of Football Numbers.

American Psychologist, 8(12), 750–751. doi: 10.1037/h0063675

Lozano, L. M., García-Cueto, E., & Muñiz, J. (2008). Effect of the number of response categories on the reliability and validity of rating scales.

Methodology: European Journal of Research Methods for the Behavioral and Social Sciences, 4(2), 73-79. doi: http://dx.doi.org/10.1027/1614-2241.4.2.73

Matell, M. S., & Jacoby, J. (1972). Is there an optimal number of alternatives for Likert-scale items? Effects of testing time and scale properties.

Journal of Applied Psychology, 56(6), 506-509. doi: http://dx.doi.org/10.1037/h0033601

Maydeu-Olivares, A., Kramp, U., García-Forero, C., Gallardo-Pujol, D., & Coffman, D. (2009). The effect of varying the number of response alternatives in rating scales: Experimental evidence from intra-individual effects.

Behavior research methods, 41, 295-308. doi:10.3758/BRM.41.2.295

McCarty, J. A. & Shrum, L. J. (2000). The Measurement of Personal Values in Survey Research: A Test of Alternative Rating Procedures.

Public Opinion Quarterly (64)271-298. doi: 10.1086/317989

McIver, J. P., & Carmines, E. G. (1993). Unidimensional scaling. In M. S. Lewis-Beck (Ed.),

Basic measurement. Beverly Hills: Sage.

Michell, J. (1986). Measurement scales and statistics: a clash of paradigms.

Psychological Bulletin, 3, 398–407.

Moors, G. 2008. Exploring the Effect of a Middle Response Category on Response Style in Attitude Measurement.

Quality & Quantity, (42)779–794. doi: http://dx.doi.org/10.1007/s11135-006-9067-x

Moosbrugger, H. & Kelava. (2012). Testtheorie und Fragebogenkonstruktion. doi: 10.1007/978-3-642-20072-4. Heidelberg: Springer-Verlag.

O’Muircheartaigh, C., Krosnick, J. & Helic, A. (2000).

Middle alternatives, acquiescence, and the quality of questionnaire data. Unveröffentlichtes Manuskript. Verfügbar unter: http://harrisschool.uchicago.edu/about/publications/workingpapers/pdf/wp_01_3.pdf.

Parducci, A. (1963). Range-frequency compromise in judgment.

Psychological Monographs: General and Applied, 77(2), 1-50. doi: http://dx.doi.org/10.1037/h0093829

Parducci, A. (1965). Category judgment: A range-frequency model.

Psychological Review, 72(6), 407-418. doi:

http://dx.doi.org/10.1037/h0022602

Preston, C. C., & Colman, A. M. (2000). Optimal number of response categories in rating scales: reliability, validity, discriminating power, and respondent preferences.

Acta Psychologica, 104(1), 1-15. doi: 10.1016/S0001-6918(99)00050-5

Prost, R. (2011).

Fragebogen. Ein Arbeitsbuch. Heidelberg: Springer-Verlag.

Rohrmann, B. (1978): Empirische Studien zur Entwicklung von Antwortskalen für die sozialwissenschaftliche Forschung.

Zeitschrift für Sozialpsychologie, 9, 222-245.

Rost, J. (2004).

Lehrbuch Testtheorie – Testkonstruktion. Bern: Huber.

Schaeffer, N. C. & Presser, S. (2003). The Science of Asking Questions.

Annual Review of Sociology, 29, 65-88.

Schwarz, N., Knauper, B., Hippler, H. J., Noelle-Neumann, E. & Clark, L. (1991). Rating Scales: Numeric Values May Change the Meaning of Scale

Labels.

Public Opinion Quarterly, 55(4), 570-582.

Spector, P. E. (1993).

Summated rating scale construction: An introduction. Florida: Sage.

Stevens, S. S. (1946). On the Theory of Scales of Measures.

Science, 103 (2684), 677-680. doi: 10.1126/science.103.2684.677

Stevens, S. S. (1951). Mathematics, measurement and psychophysics. In S. S. Stevens (Ed.),

Handbook of experimental psychology (pp. 1–49). New York: Wiley.

Stier, W. (1999).

Empirische Forschungsmethoden. Berlin: Springer-Verlag.

Stine, W. W. (1989). Meaningful inference: The role of measurement in statistics.

Psychological Bulletin, 105(1), 147-155.

Tourangeau, R., Couper, M. P., & Conrad, F. (2007). Color, labels, and interpretive heuristics for response scales.

Public Opinion Quarterly, 71(1), 91-111.

Westermann, R. (1985). Empirical tests of scale type for individual ratings.

Applied Psychological Measurement, 9(3), 265-274. doi:

http://dx.doi.org/10.1177/014662168500900304

Ähnliche Beiträge

Comments ( 7 )